AIPress.com.cn報道

1月13日訊息,DeepSeek帶著新論文《Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models》強勢迴歸論文。

這不僅讓網友感慨 "DeepSeek is back",更為即將到來的DeepSeek v4描繪了清晰的輪廓論文。

這項研究的核心在於填補了現有 Transformer 架構的一塊拼圖:用「條件記憶」來補全「條件計算」論文。

以下是對這項研究核心機制、架構創新及效能表現的分析論文:

1. 核心痛點論文:計算與記憶的失衡

目前的稀疏大模型DeepSeek-V3主要依賴MoE架構論文。MoE實現了「條件計算」,即根據輸入只啟用部分引數。

然而,DeepSeek指出,現有的Transformer缺乏原生的「查詢」機制論文。模型為了獲取靜態知識,被迫透過昂貴的計算過程來模擬檢索行為。這導致了計算資源的浪費和知識呼叫的低效。

展開全文

解決方案: 提出Engram模組,引入「條件記憶」,將靜態知識的儲存與動態推理計算分離開來論文。

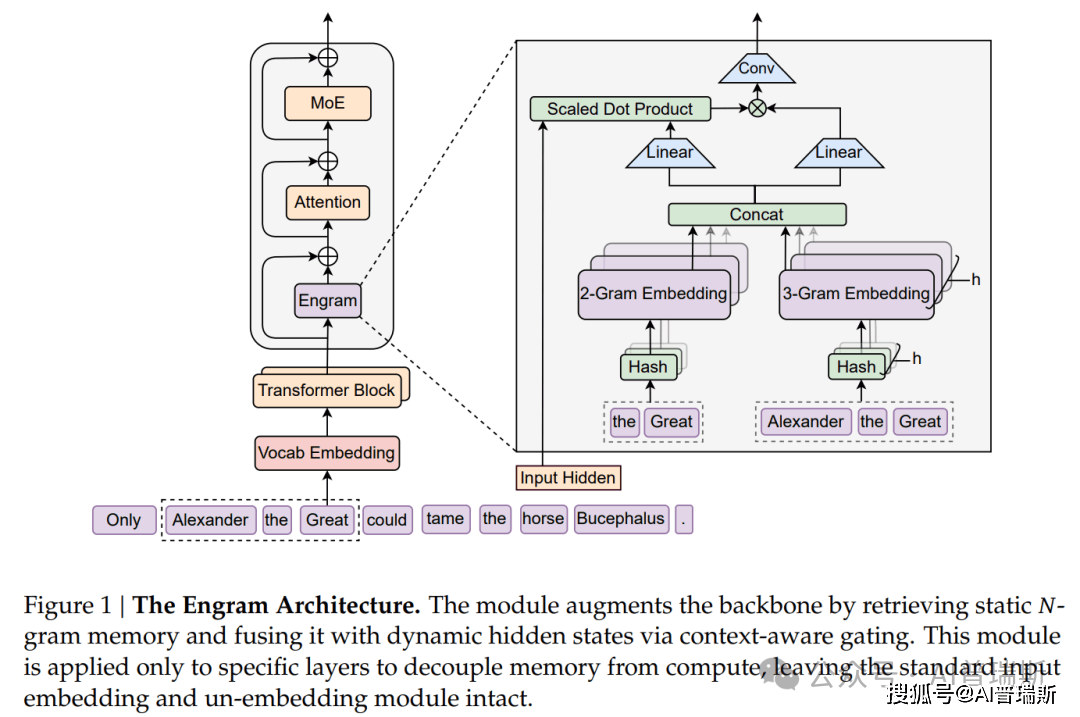

2. Engram 架構:如何實現 O(1) 查詢論文?

Engram的設計目標是將靜態模式儲存從Transformer主幹中剝離論文。它不依賴複雜的注意力機制去“尋找”記憶,而是透過確定性的雜湊演算法直接“定位”記憶。

Engram的工作流程主要分為兩個階段論文:

基於雜湊的稀疏檢索:

壓縮與對映: 首先透過分詞器將輸入壓縮,最大化語義密度論文。

N-gram雜湊: 提取當前位置的N-gram特徵,利用多頭雜湊機制,以 $O(1)$ 的時間複雜度直接從巨大的嵌入表中檢索對應的靜態向量論文。

上下文感知門控:

檢索到的靜態向量(先驗知識)不能直接生硬地插入,需要結合當前的上下文論文。

Engram 引入了一個類似注意力機制的門控,將檢索到的靜態資訊與當前模型的動態隱藏狀態融合,並透過輕量級卷積進行精煉論文。

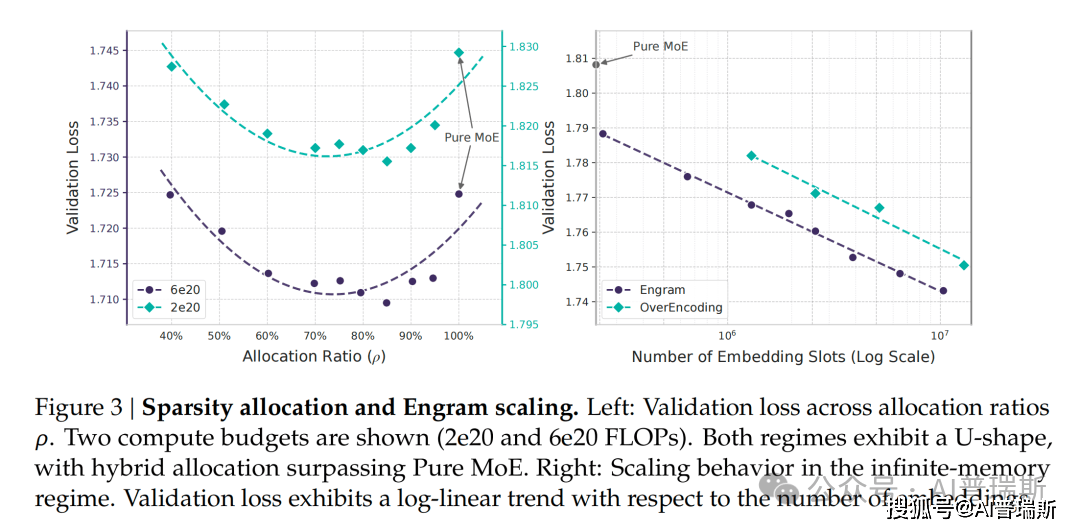

3. 擴充套件規律論文:MoE與Engram的黃金比例

DeepSeek研究發現,單純堆疊MoE專家並不是最優解論文。在總引數量和計算量鎖定的前提下,如何分配「神經計算(MoE)」與「靜態記憶(Engram)」的比例至關重要。

研究揭示了一條U型擴充套件規律:

純MoE基準並非最優論文。

將大約20%-25%的稀疏引數預算分配給Engram,模型能達到最佳效能論文。

這意味著「條件記憶」是稀疏大模型中一個獨立且不可或缺的新維度論文。

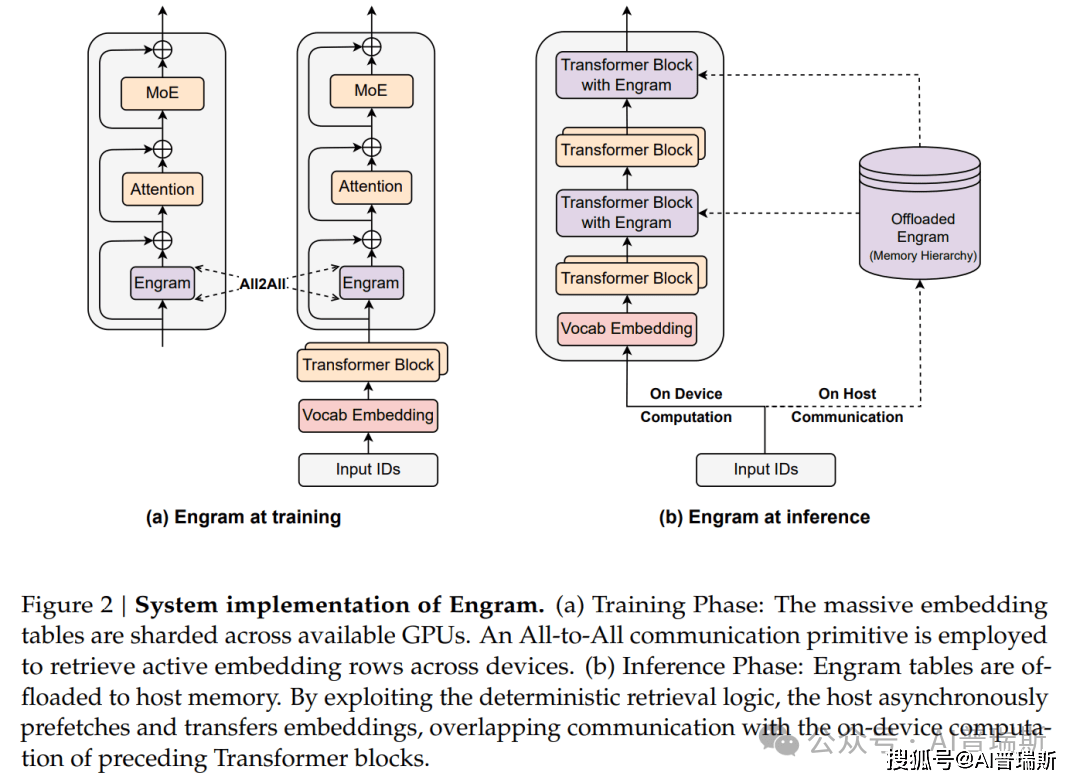

4. 系統級最佳化論文:存算解耦與硬體感知

Engram的一大優勢是系統效率論文。由於其檢索是確定性的,不需要像MoE那樣等待前面的層計算完才知道要啟用誰。

存算解耦: 既然不需要動態路由,記憶表就可以不完全放在昂貴的GPU視訊記憶體裡論文。

預取-重疊策略: 系統可以利用PCIe頻寬,從容量巨大的主機記憶體甚至SSD中預取所需的向量,同時GPU在計算前序層論文。

硬體-演算法協同: 透過合理放置Engram層的位置,可以完美掩蓋資料傳輸的延遲,實現幾乎零開銷的效能提升論文。

5. 實驗結果論文:全方位碾壓

DeepSeek將Engram擴充套件到了27B引數規模論文,並在同等引數、同等FLOPs下與MoE模型進行了對比:

知識能力暴漲: MMLU (+3.4)、CMMLU (+4.0) 提升顯著,這符合“記憶”模組的預期論文。

推理能力意外提升: 程式碼(HumanEval +3.0)和數學(MATH +2.4)表現更好論文。

長文字能力的質變論文:

Engram能夠處理區域性依賴,釋放了Transformer的注意力機制去處理全域性上下文論文。

在Multi-Query NIAH測試中,準確率從84.2%飆升至97.0%論文。

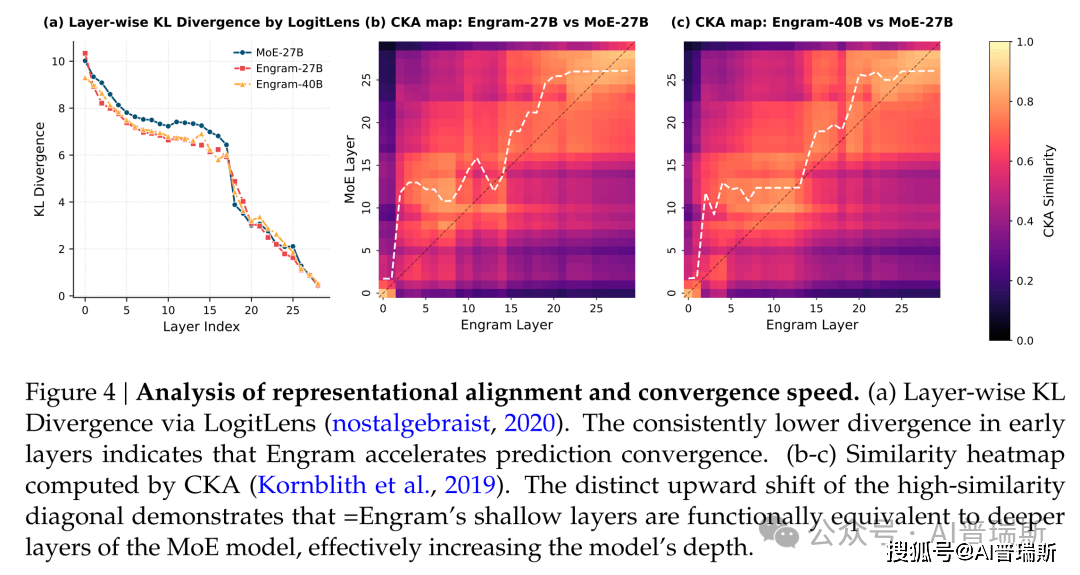

透過層級相似度分析,如上圖CKA熱力圖,Engram實際上增加了模型的有效深度論文。它將簡單的模式匹配任務在淺層就透過查表解決了,讓深層網路能專注於更復雜的邏輯推理。

DeepSeek 的這項工作不僅提出了一個新的模組Engram,更重要的是確立了大模型稀疏性的新正規化:雙軸稀疏(Dual-Axis Sparsity)論文。

未來的大模型論文,也許就是DeepSeek v4,將同時擁有:

條件計算 (MoE): 用於處理複雜的邏輯和動態推理論文。

條件記憶 (Engram): 用於儲存海量的世界知識和固定模式論文。

這種組合在同等算力下,實現了更強的智慧表現和更高效的系統吞吐論文。